los bugs comienzan a acumularse

Teknalix junio 20, 2025 No hay comentarios

La inteligencia artificial ha dejado de ser una tecnología secundaria en el desarrollo de software, de hecho, en muchas empresas, ya genera más del 50 % del código que termina en producción. Lo preocupante es que ese código, en demasiados casos, se publica sin que nadie lo haya revisado.

Cabe señalar que la velocidad con la que las herramientas de IA producen nuevas líneas de programación ha superado la capacidad de supervisión humana. Y eso ya está provocando consecuencias, con errores, vulnerabilidades y la calidad del software comienza a resentirse.

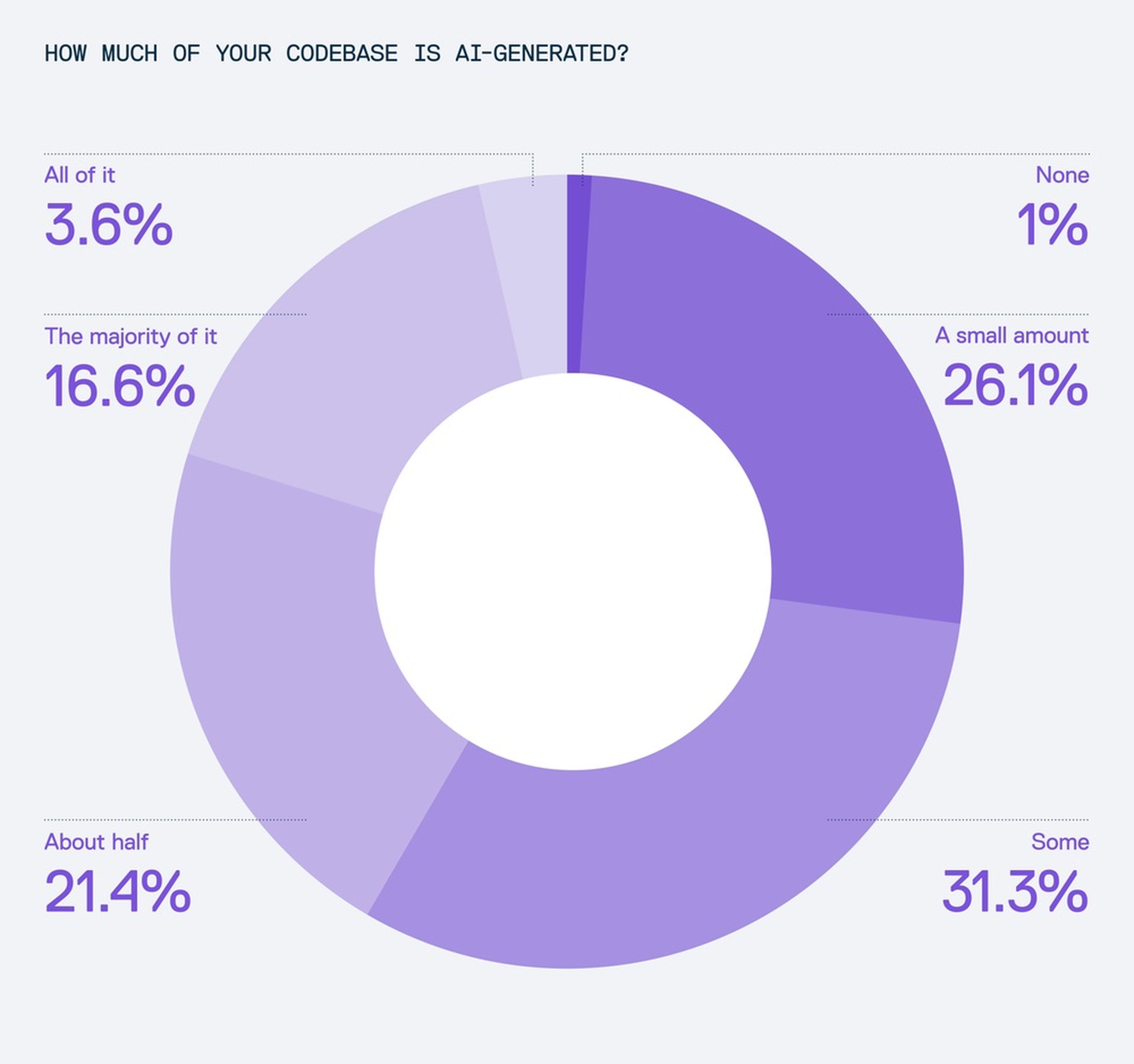

Lo que hasta hace poco parecía una predicción del futuro ya es rutina normalizada en los entornos de desarrollo, puesto que el 42 % de los programadores que utilizan chatbots afirma que al menos la mitad de su código es generado automáticamente por esta tecnología.

Algunos incluso reconocen que el 100 % de lo que escriben proviene de herramientas como GitHub Copilot, ChatGPT u otras soluciones basadas en modelos de lenguaje. Este tipo de herramientas se han integrado en el flujo de trabajo hasta el punto de que ya no se utilizan como ayuda puntual, sino como una parte fundamental del proceso de creación.

Líneas de código sin supervisión humana: un problema que puede salir muy caro

Los expertos advierten que la automatización tiene un coste que pocas organizaciones están afrontando con seriedad, puesto que a medida que la IA produce más código, los humanos se ven sobrepasados para revisarlo.

De acuerdo con el informe de Cloudsmith, un tercio de los desarrolladores admite que no examina manualmente el contenido que genera la inteligencia artificial antes de implementarlo, y es importante mencionar que no se trata solo de falta de atención o de negligencia.

AI tools/Cloudsmith

La realidad es que el volumen de producción es tal que simplemente no hay tiempo ni recursos suficientes para auditarlo todo, ya que es demasiado y no se dan abasto. El resultado es una nueva cadena de montaje en la que lo importante es entregar rápido, aunque eso suponga ignorar el riesgo.

A medida que este código no revisado se incorpora al software de uso real, los errores comienzan a multiplicarse. Desde fallos leves hasta vulnerabilidades graves, los bugs se abren paso sin que nadie los detecte a tiempo. Pero no solo se trata de errores involuntarios.

Cabe destacar que la IA también puede introducir dependencias falsas, sugerir paquetes maliciosos o replicar patrones defectuosos que haya aprendido de otros fragmentos públicos. Si ese código se publica, el problema se traslada directamente al usuario final, que utiliza una app menos segura sin saberlo.

¿Estamos en un punto de inflexión?

La empresa Cloudsmith ha puesto sobre la mesa una advertencia seria, donde afirma que el desarrollo de software ha llegado a un punto crítico. La IA generativa y todos los chatbots que utilizan las empresas ha dejado de ser un complemento y se ha convertido en un componente estructural.

Sin embargo, los mecanismos que garantizan la confianza en el código —como los controles de procedencia, la gestión de artefactos o la trazabilidad— siguen anclados en un modelo pensado para entornos manuales. Mientras tanto, la IA avanza con una velocidad que esos modelos ya no pueden seguir. El desfase crece cada día, y con él, los riesgos.

El propio informe propone una salida clara, que es automatizar la seguridad con la misma intensidad con la que se ha automatizado la generación de código. Las empresas deben implementar políticas que detecten automáticamente código no revisado, identifiquen su procedencia, evalúen los riesgos y bloqueen las implementaciones inseguras.

La trazabilidad debe ser una parte esencial del proceso desde el inicio, puesto que la revisión humana sigue siendo muy importante, pero ya no puede ser la única barrera. Si la IA genera el software, también se necesitan mecanismos automáticos que garanticen su calidad.

Tecnologías como ChatGPT, Gemini o Copilot están transformando la programación, puesto que lo hace más rápido, más accesible y más eficiente. Pero también más vulnerable, y es que el problema no está en la tecnología, sino en la falta de adaptación.

Si el desarrollo sigue avanzando sin controles proporcionales, el riesgo de errores, fallos de seguridad, así como comportamientos inestables será cada vez mayor. No se trata de volver atrás, sino de acompañar este salto tecnológico con una nueva forma de entender la seguridad.

Conoce cómo trabajamos en ComputerHoy.

Etiquetas: Inteligencia artificial

Deja un Comentario

Tu dirección de correo no será publicada. Los campos requeridos están marcados. *