“Es capaz de clasificar personas, seguirlas, saber si han ido a una protesta”

Teknalix junio 10, 2025 No hay comentarios

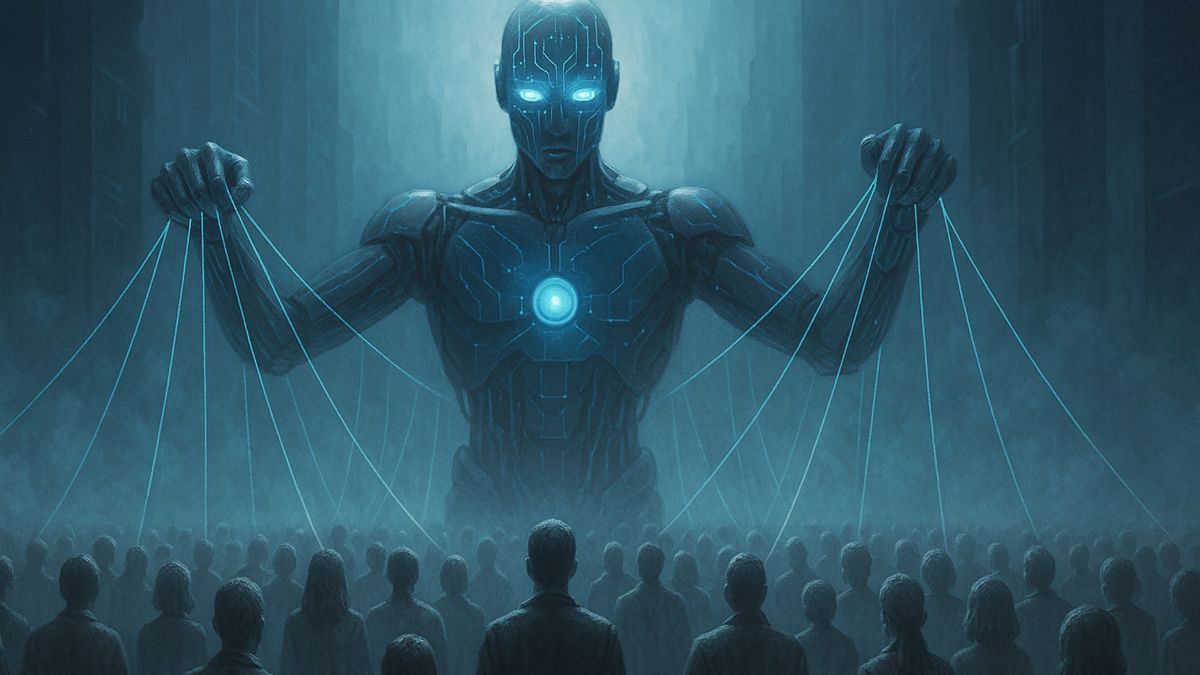

Cuando se habla de inteligencia artificial, muchas veces uno piensa en avances tecnológicos, en máquinas que aprenden solas o en robots que podrían cambiar el mundo.

Pero pocas veces uno se detiene a pensar en lo que realmente significa que estas máquinas ‘piensen’ por nosotros, o mejor dicho, que tomen decisiones que afectan a las vidas de todos sin que apenas lo notes.

Kay Firth-Butterfield lleva años comentando y advirtiendo que la IA no es solo una cuestión de avances informáticos o puramente tecnológicos, sino que tiene de por medio aspectos éticos y sociales enormes. Además, esta fue la primera persona en el mundo en tener un cargo oficial dedicado a la ética en IA, por lo que su reputación le precede.

Hoy, con el boom de herramientas como ChatGPT y otros modelos de lenguaje, la realidad ha superado la ficción. La IA está en todas partes, y si bien ha traído muchas alegrías, también está dando pie a todo tipo de problemas y miedos.

Si bien reconoce el potencial de la IA, pone sobre la mesa que “sigue siendo mala con las matemáticas, y no hemos logrado solucionar el problema de las alucinaciones”.

Esto significa que, aunque la IA puede dar respuestas rápidas y parcialmente buenas, no siempre son correctas, lo que puede ser muy peligroso en ámbitos como la educación. “Si los niños no saben la respuesta y siempre preguntan a ChatGPT, nunca aprenderán. Porque ni siquiera saben si las respuestas son correctas”, comenta.

“Estamos comprando IA por moda, no por utilidad, y eso puede salirnos caro”

Pero el problema de la IA va más allá de los errores técnicos y Firth-Butterfield explica que esta tecnología “se alimenta de nuestros sesgos y los refuerza”. En lugar de liberarnos de los prejuicios, los amplifica, perpetuando la discriminación y la desigualdad. Esto empeora con lo que llama ‘canibalismo’ de datos: los errores generados por la IA vuelven a entrar en su entrenamiento, creando un círculo vicioso.

“Todos, desde un banco hasta un ciudadano, deberíamos ser conscientes de que los datos están sesgados. Si eres un banco, deberías corregir eso dentro del sistema. Si no lo haces, podrías estar dejando de contratar a las personas adecuadas o de conceder préstamos a quien sí los merece”, explica. Y añade: “Es un problema de negocio también: podrías perder oportunidades”.

“Ahora vemos la IA como una forma de ahorrar costes en gobiernos, pero deberíamos preguntarnos: ¿deberíamos usar inteligencia artificial en este caso? ¿Cómo afecta al ciudadano?”, añade.

La IA como herramienta de vigilancia: “Incluso la hemos invitado a nuestras casas”

Uno de los mayores miedos de la experta es el potencial de la IA como herramienta de vigilancia. “La inteligencia artificial es una herramienta de vigilancia perfecta. Es capaz de clasificar personas, seguirlas, saber si han ido a una protesta”, advierte.

Y lo más inquietante es que “incluso la hemos invitado a nuestras casas”, con dispositivos que reconocen rostros y voces y que están conectados a internet. “¿De verdad queremos exponerles así?”, se pregunta refiriéndose a los niños que juegan con juguetes con IA.

“Si tú usas mal la IA, eres responsable. Pero si la herramienta está mal diseñada, entonces la responsabilidad recae en quien la hizo”. “No me gusta hablar de ética. Prefiero hablar del uso sabio de la inteligencia artificial”, afirma. Y usar la IA sabiamente implica protegerse del riesgo. “No es un dilema entre innovación o regulación. Se trata de innovar con sensatez”, añade.

Conoce cómo trabajamos en ComputerHoy.

Etiquetas: Inteligencia artificial, Software

Deja un Comentario

Tu dirección de correo no será publicada. Los campos requeridos están marcados. *